Comme vous le savez sans doute, les pages de faible qualité lorsqu’elles sont en grand nombre donnent un mauvais signal de votre site auprès des moteurs. Il y a de celà quelques temps, on a eu des exemples de sites pénalisés pour « thin content » mais des filtres algorithmiques peuvent aussi punir ce genre de pratique sans que vous le sachiez vraiment. Il y a de plus de nombreux autre critères qui peuvent dégrader la pertinence de ces même pages.

Quels sont les cas typiques de pages de mauvaises qualité ?

.Pages de faible contenu textuel

-On en trouve beaucoup même sur des sites connus, par exemple des pages produits qui ne font que lister les dimensions et la matière du produit.

-On peut citer aussi les pages wordpress avec les images indexées et… seules ! 🙂

-Ou encore des petits malins qui indexent les résultats de recherches des internautes avec leur moteur interne pour gonfler artificiellement le nombre de pages d’un site et viser des requêtes de longues traine et devenir des héros pour leur patron ;).

C’est justement cette pratique que n’aime pas trop Google, aussi il est important de s’en eloigner en préférant un nombre de pages qui réponde mieux aux requêtes avec un vrai contenu que des milliers de pages qui y répondent mal.

.Pages avec du contenu dupliqué

-Un extrait d’article qui reprend mot pour mot le contenu dans une autre page qui présente lui-même l’article.

-Un produit présent dans plusieurs catégories avec le même contenu et sans rel=canonical

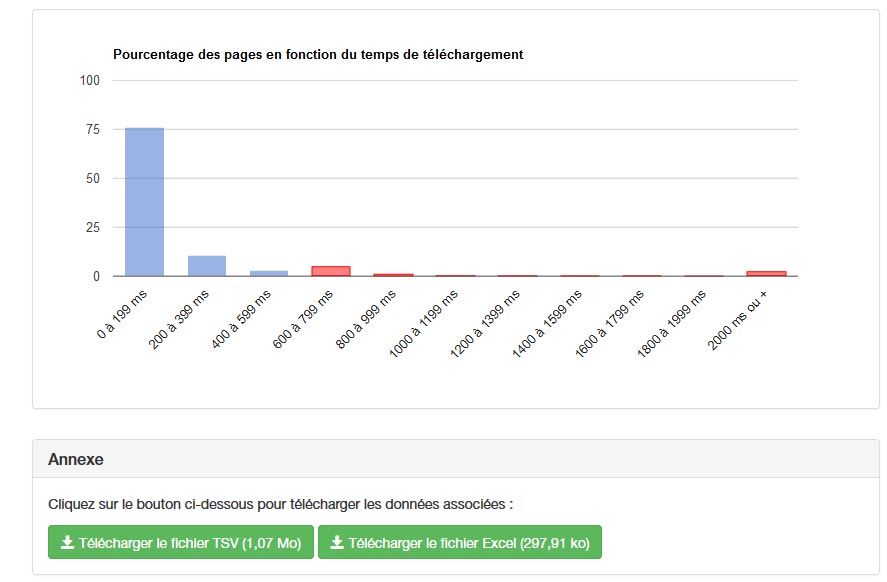

.Pages trop lourdes à télécharger

Vous avez une jolie galerie avec des photos pros importées en full hd ? Des pages produits avec des tailles d’images non optimisées ? La taille des images ou des videos qui ne sont pas en embded sont généralement les premiers indices responsables de la lenteur d’une page. Mais il y a aussi le grand nombre de javascript (.js), de css ou même de flash (oui il y en a encore…!) qui jouent également à alourdir le chargement.

.Pages orphelines :

Ce sont des pages crées et non accessible depuis la homepage de votre site ou même non accessible depuis quelque page que ce soit ! Google déteste ça et n’hésite pas à vous le faire savoir.

Dans une moindre mesure :

.Pages à la constitution non optimale : Title absent ou mal fait, balisage absent ou mal fait, métas absentes etc…

.Liens internes et externes cassés

Comment y remédier ?

Quand on a un petit site de blogging comme le mien ça peut aller assez vite, mais quand il s’agit de cleaner un très gros site e-commerce comme j’ai eu à le faire, c’est une autre paire de manches !

En effet, les équipes internes d’un tel site sont tellement concentrées sur le calendrier, les projets et autres optimisations qu’elles n’ont pas nécessairement la visibilité et le temps de le faire.

On peut déjà le faire à la main en listant ces pages ou bien s’aider un logiciel de crawl comme Xenu ou screaming frog pour voir des pages qui répondent en erreur, des titles bizarres etc.. mais là aussi celà prend un temps précieux. Tout seo ou responsable d’activité web vous dira que le temps est précieux et que souvent une partie de la réussite s’inscrit dans la capacité de sous-traiter et faire de l’automation dans certains domaines.

Il y a quelques tools existants qui peuvent « désherber » le terrain en vous permettant d’identifier corriger de manière massive la majeure partie des principaux points bloquants. On pense évidemment aux outils d’analyse de logs par exemple, mais j’ai profité de ma venue à la formation de ranking metrics pour avoir eu l’opportunité de tester « My Ranking Metrics » lancé par O.Duffez.

Olivier prône justement la qualité des pages en tant que signal on-site primordial, c’est ce que met en avant justement son outil.

Autant mettre à l’aise tout newbie, l’outil en ligne est très pédagogique et c’est sans doute sa force car nul besoin d’être un grand spécialiste du référencement pour décortiquer comment il fonctionne.

Comment celà fonctionne ?

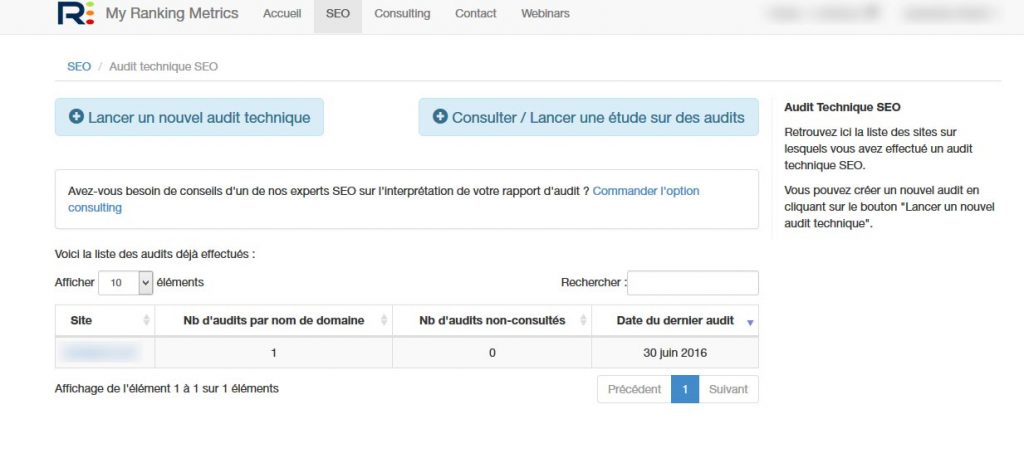

C’est très simple : il suffit de lancer un « audit technique », le tool scrappe alors un nombre d’url que vous avez défini initialement. Il vous pond alors un rapport détaillé que vous pouvez voir ci-dessous. (à noter que vous pouvez lancer autant d’audit que vous voulez, ils s’ajouteront en mode liste sur votre compte)

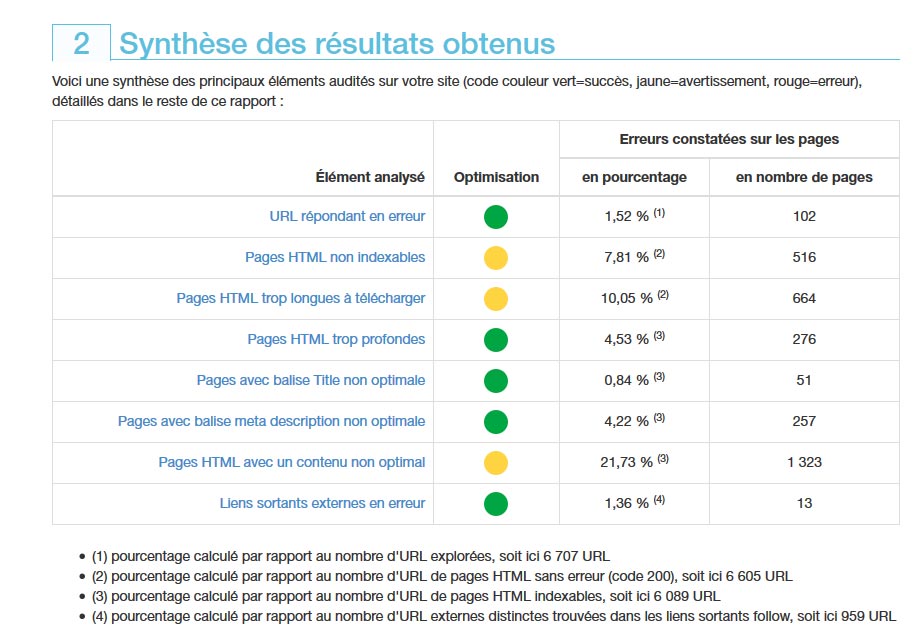

Chaque partie jugée importante est notée dans une synthèse par une couleur de puce qui est plus ou moins rouge selon le signal renvoyé par le site. A noter que chaque strate de ce crawl est expliqué en détails et téléchargeable pour que les equipes techniques puissent se concentrer sur des chantiers particuliers.

Par quoi commencer ?

Si vous avez un site e-commerce ou un site de news, l’objectif ne sera sans doute pas le même. Dans le cadre d’un site e-commerce, ce sont les points bloquants typiques au business qui seront primordiaux : est-ce que les pages sont visitées même si elles sont bancales ? Est-ce qu’elles génèrent du chiffre ?

Si c’est un site de contenus brut, il faudra alors regarder les titles courts ou absents, les contenus faible etc… olivier en parle en détail dans ce billet.

Est-ce que ça marche ?

Je ne vais pas vous mentir, je suis aussi convaincu qu’un signal « clean » d’un site web est un facteur important. Des études américaines récentes ont montré une amélioration du ranking avec un site propre, et dans mon cas il y a eu des résultats surtout sur de la moyenne traine qui était impactée.

Aprés, pour être transparent, l’outil ne va pas tout faire à votre place mais il va vous faire gagner un temps précieux et son explication détaillée tout au long du process est un bon moyen d’expliquer des points bloquants à vos supérieurs par exemple, c’est pourquoi je vous le recommande surtout pour des sites imposants.

Pour en savoir plus :

http://www.webrankinfo.com/dossiers/ranking-metrics/quality-risk

https://myrankingmetrics.com/